@@ -326,35 +352,35 @@ $ docker run -d --name mycontainer -p 80:80 myimage

-## Проверка

+## Проверка { #check-it }

-Вы можете проверить, что Ваш Docker-контейнер работает перейдя по ссылке: http://192.168.99.100/items/5?q=somequery или http://127.0.0.1/items/5?q=somequery (или похожей, которую использует Ваш Docker-хост).

+Проверьте работу по адресу вашего Docker-хоста, например: http://192.168.99.100/items/5?q=somequery или http://127.0.0.1/items/5?q=somequery (или аналогичный URL вашего Docker-хоста).

-Там вы увидите:

+Вы увидите что-то вроде:

```JSON

{"item_id": 5, "q": "somequery"}

```

-## Интерактивная документация API

+## Интерактивная документация API { #interactive-api-docs }

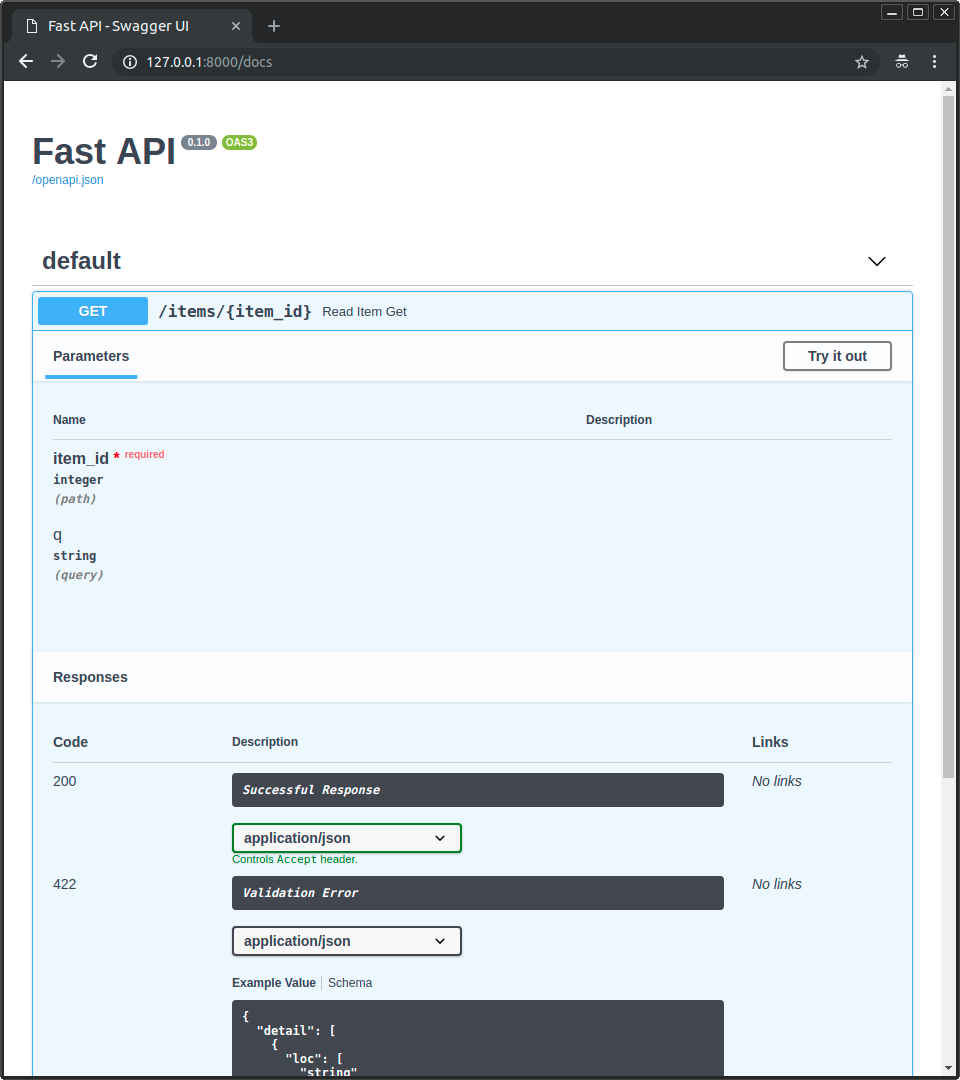

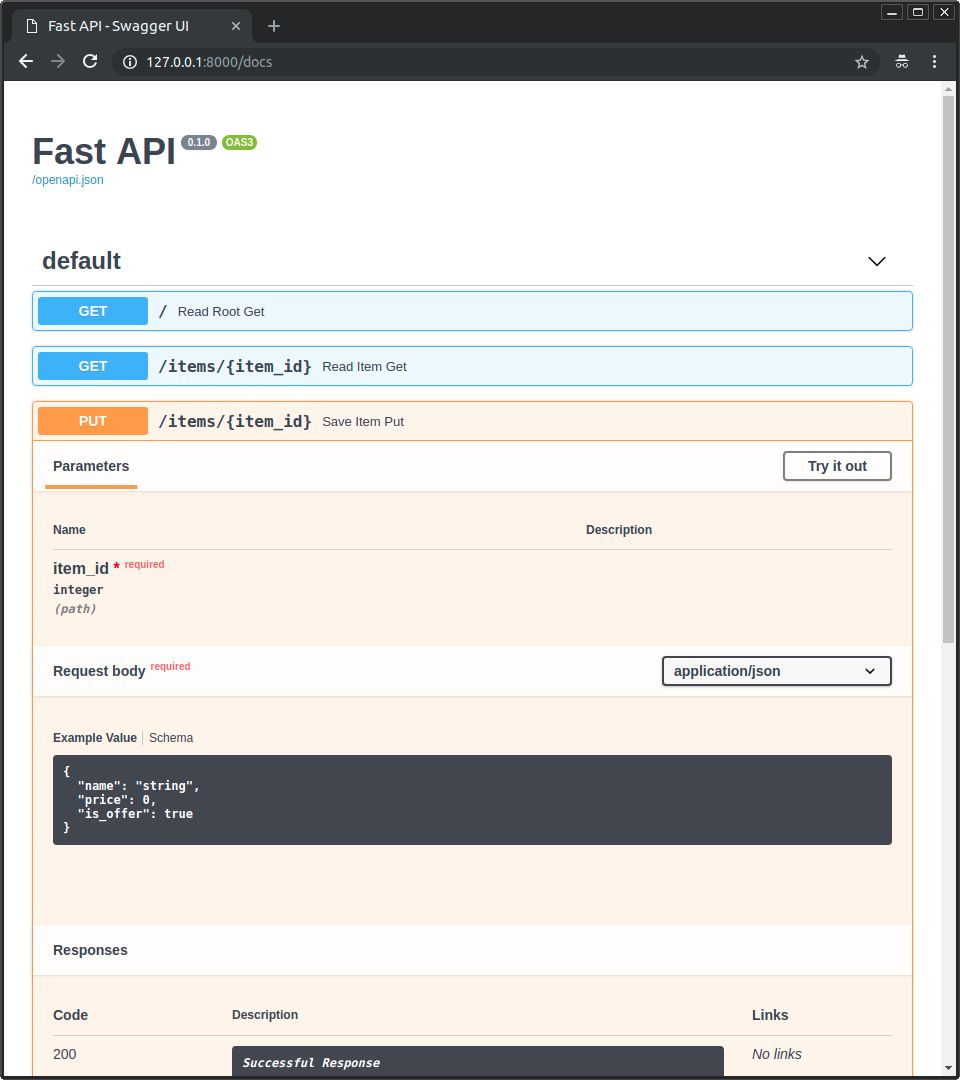

-Теперь перейдите по ссылке http://192.168.99.100/docs или http://127.0.0.1/docs (или похожей, которую использует Ваш Docker-хост).

+Теперь зайдите на http://192.168.99.100/docs или http://127.0.0.1/docs (или аналогичный URL вашего Docker-хоста).

-Здесь вы увидите автоматическую интерактивную документацию API (предоставляемую Swagger UI):

+Вы увидите автоматическую интерактивную документацию API (на базе Swagger UI):

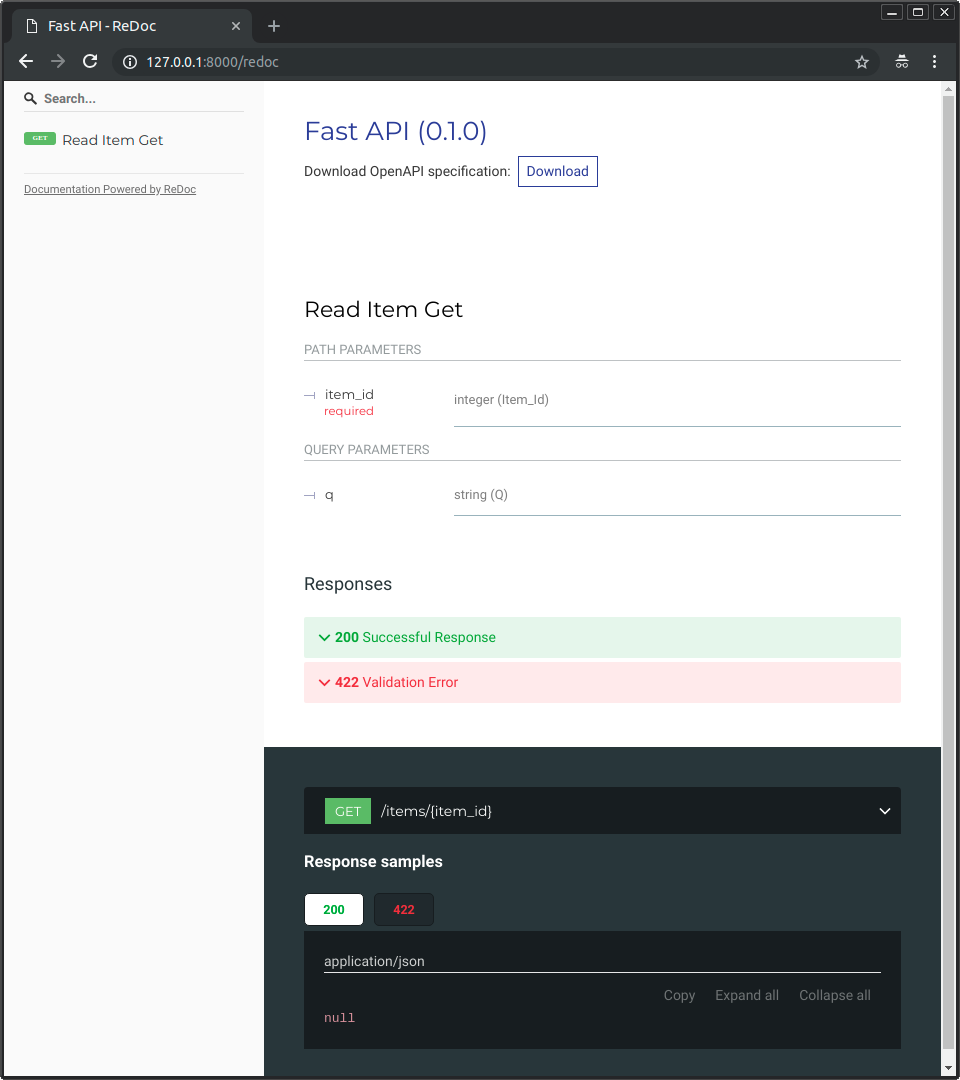

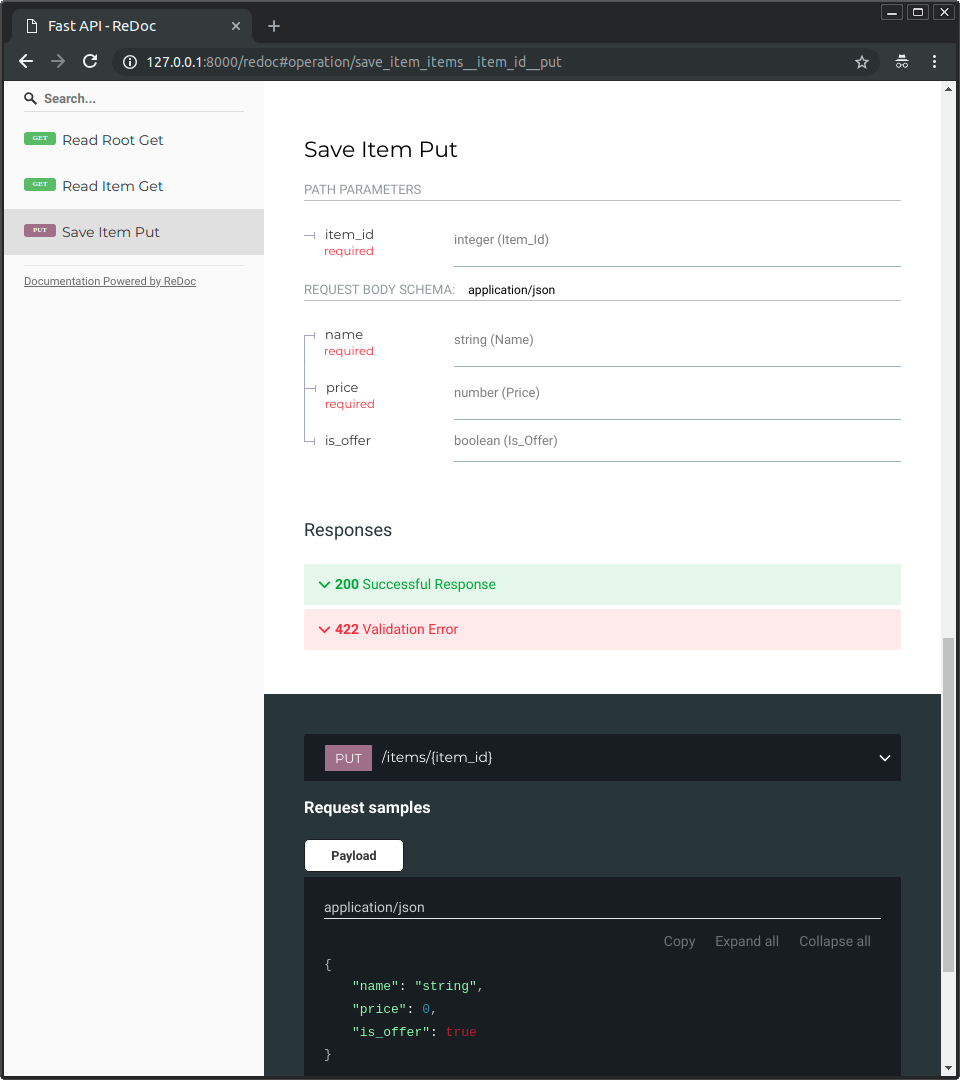

-## Альтернативная документация API

+## Альтернативная документация API { #alternative-api-docs }

-Также вы можете перейти по ссылке http://192.168.99.100/redoc or http://127.0.0.1/redoc (или похожей, которую использует Ваш Docker-хост).

+Также можно открыть http://192.168.99.100/redoc или http://127.0.0.1/redoc (или аналогичный URL вашего Docker-хоста).

-Здесь вы увидите альтернативную автоматическую документацию API (предоставляемую ReDoc):

+Вы увидите альтернативную автоматическую документацию (на базе ReDoc):

-## Создание Docker-образа на основе однофайлового приложения FastAPI

+## Собрать Docker-образ для однофайлового FastAPI { #build-a-docker-image-with-a-single-file-fastapi }

-Если ваше приложение FastAPI помещено в один файл, например, `main.py` и структура Ваших файлов похожа на эту:

+Если ваше приложение FastAPI — один файл, например `main.py` без директории `./app`, структура файлов может быть такой:

```

.

@@ -363,7 +389,7 @@ $ docker run -d --name mycontainer -p 80:80 myimage

└── requirements.txt

```

-Вам нужно изменить в `Dockerfile` соответствующие пути копирования файлов:

+Тогда в `Dockerfile` нужно изменить пути копирования:

```{ .dockerfile .annotate hl_lines="10 13" }

FROM python:3.9

@@ -374,360 +400,221 @@ COPY ./requirements.txt /code/requirements.txt

RUN pip install --no-cache-dir --upgrade -r /code/requirements.txt

-# (1)

+# (1)!

COPY ./main.py /code/

-# (2)

-CMD ["uvicorn", "main:app", "--host", "0.0.0.0", "--port", "80"]

+# (2)!

+CMD ["fastapi", "run", "main.py", "--port", "80"]

```

-1. Скопируйте непосредственно файл `main.py` в директорию `/code` (не указывайте `./app`).

+1. Копируем файл `main.py` напрямую в `/code` (без директории `./app`).

-2. При запуске Uvicorn укажите ему, что объект `app` нужно импортировать из файла `main` (вместо импортирования из `app.main`).

+2. Используем `fastapi run` для запуска приложения из одного файла `main.py`.

-Настройте Uvicorn на использование `main` вместо `app.main` для импорта объекта `app`.

+Когда вы передаёте файл в `fastapi run`, он автоматически определит, что это одиночный файл, а не часть пакета, и поймёт, как его импортировать и запустить ваше FastAPI-приложение. 😎

-## Концепции развёртывания

+## Концепции развертывания { #deployment-concepts }

-Давайте вспомним о [Концепциях развёртывания](concepts.md){.internal-link target=_blank} и применим их к контейнерам.

+Ещё раз рассмотрим [концепции развертывания](concepts.md){.internal-link target=_blank} применительно к контейнерам.

-Контейнеры - это, в основном, инструмент упрощающий **сборку и развёртывание** приложения и они не обязывают к применению какой-то определённой **концепции развёртывания**, а значит мы можем выбирать нужную стратегию.

+Контейнеры главным образом упрощают **сборку и развёртывание** приложения, но не навязывают конкретный подход к этим **концепциям развертывания**, и существует несколько стратегий.

-**Хорошая новость** в том, что независимо от выбранной стратегии, мы всё равно можем покрыть все концепции развёртывания. 🎉

+**Хорошая новость** в том, что при любой стратегии есть способ охватить все концепции развертывания. 🎉

-Рассмотрим эти **концепции развёртывания** применительно к контейнерам:

+Рассмотрим эти **концепции развертывания** в терминах контейнеров:

-* Использование более безопасного протокола HTTPS

-* Настройки запуска приложения

-* Перезагрузка приложения

-* Запуск нескольких экземпляров приложения

-* Управление памятью

-* Использование перечисленных функций перед запуском приложения

+* HTTPS

+* Запуск при старте

+* Перезапуски

+* Репликация (количество запущенных процессов)

+* Память

+* Предварительные шаги перед запуском

-## Использование более безопасного протокола HTTPS

+## HTTPS { #https }

-Если мы определимся, что **образ контейнера** будет содержать только приложение FastAPI, то работу с HTTPS можно организовать **снаружи** контейнера при помощи другого инструмента.

+Если мы рассматриваем только **образ контейнера** для приложения FastAPI (и далее запущенный **контейнер**), то HTTPS обычно обрабатывается **внешним** инструментом.

-Это может быть другой контейнер, в котором есть, например, Traefik, работающий с **HTTPS** и **самостоятельно** обновляющий **сертификаты**.

+Это может быть другой контейнер, например с Traefik, который берёт на себя **HTTPS** и **автоматическое** получение **сертификатов**.

/// tip | Подсказка

-Traefik совместим с Docker, Kubernetes и им подобными инструментами. Он очень прост в установке и настройке использования HTTPS для Ваших контейнеров.

+У Traefik есть интеграции с Docker, Kubernetes и другими, поэтому очень легко настроить и сконфигурировать HTTPS для ваших контейнеров.

///

-В качестве альтернативы, работу с HTTPS можно доверить облачному провайдеру, если он предоставляет такую услугу.

+В качестве альтернативы HTTPS может быть реализован как сервис облачного провайдера (при этом приложение всё равно работает в контейнере).

-## Настройки запуска и перезагрузки приложения

+## Запуск при старте и перезапуски { #running-on-startup-and-restarts }

-Обычно **запуском контейнера с приложением** занимается какой-то отдельный инструмент.

+Обычно есть другой инструмент, отвечающий за **запуск и работу** вашего контейнера.

-Это может быть сам **Docker**, **Docker Compose**, **Kubernetes**, **облачный провайдер** и т.п.

+Это может быть сам **Docker**, **Docker Compose**, **Kubernetes**, **облачный сервис** и т.п.

-В большинстве случаев это простейшие настройки запуска и перезагрузки приложения (при падении). Например, команде запуска Docker-контейнера можно добавить опцию `--restart`.

+В большинстве (или во всех) случаев есть простая опция, чтобы включить запуск контейнера при старте системы и перезапуски при сбоях. Например, в Docker это опция командной строки `--restart`.

-Управление запуском и перезагрузкой приложений без использования контейнеров - весьма затруднительно. Но при **работе с контейнерами** - это всего лишь функционал доступный по умолчанию. ✨

+Без контейнеров обеспечить запуск при старте и перезапуски может быть сложно. Но при **работе с контейнерами** в большинстве случаев этот функционал доступен по умолчанию. ✨

-## Запуск нескольких экземпляров приложения - Указание количества процессов

+## Репликация — количество процессов { #replication-number-of-processes }

-Если у вас есть кластер машин под управлением **Kubernetes**, Docker Swarm Mode, Nomad или аналогичной сложной системой оркестрации контейнеров, скорее всего, вместо использования менеджера процессов (типа Gunicorn и его воркеры) в каждом контейнере, вы захотите **управлять количеством запущенных экземпляров приложения** на **уровне кластера**.

+Если у вас есть кластер машин с **Kubernetes**, Docker Swarm Mode, Nomad или другой похожей системой для управления распределёнными контейнерами на нескольких машинах, скорее всего вы будете **управлять репликацией** на **уровне кластера**, а не использовать **менеджер процессов** (например, Uvicorn с воркерами) в каждом контейнере.

-В любую из этих систем управления контейнерами обычно встроен способ управления **количеством запущенных контейнеров** для распределения **нагрузки** от входящих запросов на **уровне кластера**.

+Одна из таких систем управления распределёнными контейнерами, как Kubernetes, обычно имеет встроенный способ управлять **репликацией контейнеров**, поддерживая **балансировку нагрузки** для входящих запросов — всё это на **уровне кластера**.

-В такой ситуации Вы, вероятно, захотите создать **образ Docker**, как [описано выше](#dockerfile), с установленными зависимостями и запускающий **один процесс Uvicorn** вместо того, чтобы запускать Gunicorn управляющий несколькими воркерами Uvicorn.

+В таких случаях вы, скорее всего, захотите собрать **Docker-образ с нуля**, как [описано выше](#dockerfile), установить зависимости и запускать **один процесс Uvicorn** вместо множества воркеров Uvicorn.

-### Балансировщик нагрузки

+### Балансировщик нагрузки { #load-balancer }

-Обычно при использовании контейнеров один компонент **прослушивает главный порт**. Это может быть контейнер содержащий **прокси-сервер завершения работы TLS** для работы с **HTTPS** или что-то подобное.

+При использовании контейнеров обычно есть компонент, **слушающий главный порт**. Это может быть другой контейнер — **прокси завершения TLS** для обработки **HTTPS** или похожий инструмент.

-Поскольку этот компонент **принимает запросы** и равномерно **распределяет** их между компонентами, его также называют **балансировщиком нагрузки**.

+Поскольку этот компонент принимает **нагрузку** запросов и распределяет её между воркерами **сбалансированно**, его часто называют **балансировщиком нагрузки**.

/// tip | Подсказка

-**Прокси-сервер завершения работы TLS** одновременно может быть **балансировщиком нагрузки**.

+Тот же компонент **прокси завершения TLS**, который обрабатывает HTTPS, скорее всего также будет **балансировщиком нагрузки**.

///

-Система оркестрации, которую вы используете для запуска и управления контейнерами, имеет встроенный инструмент **сетевого взаимодействия** (например, для передачи HTTP-запросов) между контейнерами с Вашими приложениями и **балансировщиком нагрузки** (который также может быть **прокси-сервером**).

+При работе с контейнерами система, которую вы используете для запуска и управления ими, уже имеет внутренние средства для передачи **сетевого взаимодействия** (например, HTTP-запросов) от **балансировщика нагрузки** (который также может быть **прокси завершения TLS**) к контейнеру(-ам) с вашим приложением.

-### Один балансировщик - Множество контейнеров

+### Один балансировщик — несколько контейнеров-воркеров { #one-load-balancer-multiple-worker-containers }

-При работе с **Kubernetes** или аналогичными системами оркестрации использование их внутренней сети позволяет иметь один **балансировщик нагрузки**, который прослушивает **главный** порт и передаёт запросы **множеству запущенных контейнеров** с Вашими приложениями.

+При работе с **Kubernetes** или похожими системами управления распределёнными контейнерами их внутренние механизмы сети позволяют одному **балансировщику нагрузки**, слушающему главный **порт**, передавать запросы в **несколько контейнеров**, где запущено ваше приложение.

-В каждом из контейнеров обычно работает **только один процесс** (например, процесс Uvicorn управляющий Вашим приложением FastAPI). Контейнеры могут быть **идентичными**, запущенными на основе одного и того же образа, но у каждого будут свои отдельные процесс, память и т.п. Таким образом мы получаем преимущества **распараллеливания** работы по **разным ядрам** процессора или даже **разным машинам**.

+Каждый такой контейнер с вашим приложением обычно имеет **только один процесс** (например, процесс Uvicorn с вашим приложением FastAPI). Все они — **одинаковые контейнеры**, запускающие одно и то же, но у каждого свой процесс, память и т.п. Так вы используете **параллелизм** по **разным ядрам** CPU или даже **разным машинам**.

-Система управления контейнерами с **балансировщиком нагрузки** будет **распределять запросы** к контейнерам с приложениями **по очереди**. То есть каждый запрос будет обработан одним из множества **одинаковых контейнеров** с одним и тем же приложением.

+Система распределённых контейнеров с **балансировщиком нагрузки** будет **распределять запросы** между контейнерами с вашим приложением **по очереди**. То есть каждый запрос может обрабатываться одним из нескольких **реплицированных контейнеров**.

-**Балансировщик нагрузки** может обрабатывать запросы к *разным* приложениям, расположенным в вашем кластере (например, если у них разные домены или префиксы пути) и передавать запросы нужному контейнеру с требуемым приложением.

+Обычно такой **балансировщик нагрузки** может также обрабатывать запросы к *другим* приложениям в вашем кластере (например, к другому домену или под другим префиксом пути URL) и направлять их к нужным контейнерам этого *другого* приложения.

-### Один процесс на контейнер

+### Один процесс на контейнер { #one-process-per-container }

-В этом варианте **в одном контейнере будет запущен только один процесс (Uvicorn)**, а управление изменением количества запущенных копий приложения происходит на уровне кластера.

+В таком сценарии, скорее всего, вы захотите иметь **один (Uvicorn) процесс на контейнер**, так как репликация уже управляется на уровне кластера.

-Здесь **не нужен** менеджер процессов типа Gunicorn, управляющий процессами Uvicorn, или же Uvicorn, управляющий другими процессами Uvicorn. Достаточно **только одного процесса Uvicorn** на контейнер (но запуск нескольких процессов не запрещён).

+Поэтому в контейнере **не нужно** поднимать несколько воркеров, например через опцию командной строки `--workers`. Нужен **один процесс Uvicorn** на контейнер (но, возможно, несколько контейнеров).

-Использование менеджера процессов (Gunicorn или Uvicorn) внутри контейнера только добавляет **излишнее усложнение**, так как управление следует осуществлять системой оркестрации.

+Наличие отдельного менеджера процессов внутри контейнера (как при нескольких воркерах) только добавит **лишнюю сложность**, которую, вероятно, уже берёт на себя ваша кластерная система.

-### Множество процессов внутри контейнера для особых случаев

+### Контейнеры с несколькими процессами и особые случаи { #containers-with-multiple-processes-and-special-cases }

-Безусловно, бывают **особые случаи**, когда может понадобиться внутри контейнера запускать **менеджер процессов Gunicorn**, управляющий несколькими **процессами Uvicorn**.

+Конечно, есть **особые случаи**, когда может понадобиться **контейнер** с несколькими **воркерами Uvicorn** внутри.

-Для таких случаев вы можете использовать **официальный Docker-образ** (прим. пер: - *здесь и далее на этой странице, если вы встретите сочетание "официальный Docker-образ" без уточнений, то автор имеет в виду именно предоставляемый им образ*), где в качестве менеджера процессов используется **Gunicorn**, запускающий несколько **процессов Uvicorn** и некоторые настройки по умолчанию, автоматически устанавливающие количество запущенных процессов в зависимости от количества ядер вашего процессора. Я расскажу вам об этом подробнее тут: [Официальный Docker-образ со встроенными Gunicorn и Uvicorn](#docker-gunicorn-uvicorn).

+В таких случаях вы можете использовать опцию командной строки `--workers`, чтобы указать нужное количество воркеров:

-Некоторые примеры подобных случаев:

+```{ .dockerfile .annotate }

+FROM python:3.9

-#### Простое приложение

+WORKDIR /code

-Вы можете использовать менеджер процессов внутри контейнера, если ваше приложение **настолько простое**, что у вас нет необходимости (по крайней мере, пока нет) в тщательных настройках количества процессов и вам достаточно имеющихся настроек по умолчанию (если используется официальный Docker-образ) для запуска приложения **только на одном сервере**, а не в кластере.

+COPY ./requirements.txt /code/requirements.txt

-#### Docker Compose

+RUN pip install --no-cache-dir --upgrade -r /code/requirements.txt

-С помощью **Docker Compose** можно разворачивать несколько контейнеров на **одном сервере** (не кластере), но при это у вас не будет простого способа управления количеством запущенных контейнеров с одновременным сохранением общей сети и **балансировки нагрузки**.

+COPY ./app /code/app

-В этом случае можно использовать **менеджер процессов**, управляющий **несколькими процессами**, внутри **одного контейнера**.

+# (1)!

+CMD ["fastapi", "run", "app/main.py", "--port", "80", "--workers", "4"]

+```

-#### Prometheus и прочие причины

+1. Здесь мы используем опцию `--workers`, чтобы установить число воркеров равным 4.

-У вас могут быть и **другие причины**, когда использование **множества процессов** внутри **одного контейнера** будет проще, нежели запуск **нескольких контейнеров** с **единственным процессом** в каждом из них.

+Примеры, когда это может быть уместно:

-Например (в зависимости от конфигурации), у вас могут быть инструменты подобные экспортёру Prometheus, которые должны иметь доступ к **каждому запросу** приходящему в контейнер.

+#### Простое приложение { #a-simple-app }

-Если у вас будет **несколько контейнеров**, то Prometheus, по умолчанию, **при сборе метрик** получит их **только с одного контейнера**, который обрабатывает конкретный запрос, вместо **сбора метрик** со всех работающих контейнеров.

+Вам может понадобиться менеджер процессов в контейнере, если приложение **достаточно простое**, чтобы запускаться на **одном сервере**, а не в кластере.

-В таком случае может быть проще иметь **один контейнер** со **множеством процессов**, с нужным инструментом (таким как экспортёр Prometheus) в этом же контейнере и собирающем метрики со всех внутренних процессов этого контейнера.

+#### Docker Compose { #docker-compose }

+

+Вы можете развёртывать на **одном сервере** (не кластере) с **Docker Compose**, и у вас не будет простого способа управлять репликацией контейнеров (в Docker Compose), сохраняя общую сеть и **балансировку нагрузки**.

+

+Тогда вы можете захотеть **один контейнер** с **менеджером процессов**, который запускает **несколько воркеров** внутри.

---

-Самое главное - **ни одно** из перечисленных правил не является **высеченным на камне** и вы не обязаны слепо их повторять. вы можете использовать эти идеи при **рассмотрении вашего конкретного случая** и самостоятельно решать, какая из концепции подходит лучше:

+Главное — **ни одно** из этих правил не является **строго обязательным**. Используйте эти идеи, чтобы **оценить свой конкретный случай** и решить, какой подход лучше для вашей системы, учитывая:

-* Использование более безопасного протокола HTTPS

-* Настройки запуска приложения

-* Перезагрузка приложения

-* Запуск нескольких экземпляров приложения

-* Управление памятью

-* Использование перечисленных функций перед запуском приложения

+* Безопасность — HTTPS

+* Запуск при старте

+* Перезапуски

+* Репликацию (количество запущенных процессов)

+* Память

+* Предварительные шаги перед запуском

-## Управление памятью

+## Память { #memory }

-При **запуске одного процесса на контейнер** вы получаете относительно понятный, стабильный и ограниченный объём памяти, потребляемый одним контейнером.

+Если вы запускаете **один процесс на контейнер**, у каждого контейнера будет более-менее чётко определённый, стабильный и ограниченный объём потребляемой памяти (контейнеров может быть несколько при репликации).

-Вы можете установить аналогичные ограничения по памяти при конфигурировании своей системы управления контейнерами (например, **Kubernetes**). Таким образом система сможет **изменять количество контейнеров** на **доступных ей машинах** приводя в соответствие количество памяти нужной контейнерам с количеством памяти доступной в кластере (наборе доступных машин).

+Затем вы можете задать такие же лимиты и требования по памяти в конфигурации вашей системы управления контейнерами (например, в **Kubernetes**). Так система сможет **реплицировать контейнеры** на **доступных машинах**, учитывая объём необходимой памяти и доступной памяти в машинах кластера.

-Если у вас **простенькое** приложение, вероятно у вас не будет **необходимости** устанавливать жёсткие ограничения на выделяемую ему память. Но если приложение **использует много памяти** (например, оно использует модели **машинного обучения**), вам следует проверить, как много памяти ему требуется и отрегулировать **количество контейнеров** запущенных на **каждой машине** (может быть даже добавить машин в кластер).

+Если приложение **простое**, это, вероятно, **не будет проблемой**, и жёсткие лимиты памяти можно не указывать. Но если вы **используете много памяти** (например, с моделями **Машинного обучения**), проверьте, сколько памяти потребляется, и отрегулируйте **число контейнеров** на **каждой машине** (и, возможно, добавьте машины в кластер).

-Если вы запускаете **несколько процессов в контейнере**, то должны быть уверены, что эти процессы не **займут памяти больше**, чем доступно для контейнера.

+Если вы запускаете **несколько процессов в контейнере**, нужно убедиться, что их суммарное потребление **не превысит доступную память**.

-## Подготовительные шаги при запуске контейнеров

+## Предварительные шаги перед запуском и контейнеры { #previous-steps-before-starting-and-containers }

-Есть два основных подхода, которые вы можете использовать при запуске контейнеров (Docker, Kubernetes и т.п.).

+Если вы используете контейнеры (например, Docker, Kubernetes), есть два основных подхода.

-### Множество контейнеров

+### Несколько контейнеров { #multiple-containers }

-Когда вы запускаете **множество контейнеров**, в каждом из которых работает **только один процесс** (например, в кластере **Kubernetes**), может возникнуть необходимость иметь **отдельный контейнер**, который осуществит **предварительные шаги перед запуском** остальных контейнеров (например, применяет миграции к базе данных).

+Если у вас **несколько контейнеров**, и, вероятно, каждый запускает **один процесс** (например, в кластере **Kubernetes**), то вы, скорее всего, захотите иметь **отдельный контейнер**, выполняющий **предварительные шаги** в одном контейнере и одном процессе **до** запуска реплицированных контейнеров-воркеров.

/// info | Информация

-При использовании Kubernetes, это может быть Инициализирующий контейнер.

+Если вы используете Kubernetes, это, вероятно, будет Init Container.

///

-При отсутствии такой необходимости (допустим, не нужно применять миграции к базе данных, а только проверить, что она готова принимать соединения), вы можете проводить такую проверку в каждом контейнере перед запуском его основного процесса и запускать все контейнеры **одновременно**.

-

-### Только один контейнер

-

-Если у вас несложное приложение для работы которого достаточно **одного контейнера**, но в котором работает **несколько процессов** (или один процесс), то прохождение предварительных шагов можно осуществить в этом же контейнере до запуска основного процесса. Официальный Docker-образ поддерживает такие действия.

+Если в вашем случае нет проблемы с тем, чтобы выполнять эти предварительные шаги **многократно и параллельно** (например, вы не запускаете миграции БД, а только проверяете готовность БД), вы можете просто выполнить их в каждом контейнере прямо перед стартом основного процесса.

-## Официальный Docker-образ с Gunicorn и Uvicorn

+### Один контейнер { #single-container }

-Я подготовил для вас Docker-образ, в который включён Gunicorn управляющий процессами (воркерами) Uvicorn, в соответствии с концепциями рассмотренными в предыдущей главе: [Рабочие процессы сервера (воркеры) - Gunicorn совместно с Uvicorn](server-workers.md){.internal-link target=_blank}.

+Если у вас простая схема с **одним контейнером**, который затем запускает несколько **воркеров** (или один процесс), можно выполнить подготовительные шаги в этом же контейнере непосредственно перед запуском процесса с приложением.

-Этот образ может быть полезен для ситуаций описанных тут: [Множество процессов внутри контейнера для особых случаев](#_11).

-

-* tiangolo/uvicorn-gunicorn-fastapi.

-

-/// warning | Предупреждение

+### Базовый Docker-образ { #base-docker-image }

-Скорее всего у вас **нет необходимости** в использовании этого образа или подобного ему и лучше создать свой образ с нуля как описано тут: [Создать Docker-образ для FastAPI](#docker-fastapi).

+Ранее существовал официальный Docker-образ FastAPI: tiangolo/uvicorn-gunicorn-fastapi. Сейчас он помечен как устаревший. ⛔️

-///

+Скорее всего, вам **не стоит** использовать этот базовый образ (или какой-либо аналогичный).

-В этом образе есть **автоматический** механизм подстройки для запуска **необходимого количества процессов** в соответствии с доступным количеством ядер процессора.

+Если вы используете **Kubernetes** (или другое) и уже настраиваете **репликацию** на уровне кластера через несколько **контейнеров**, в этих случаях лучше **собрать образ с нуля**, как описано выше: [Создать Docker-образ для FastAPI](#build-a-docker-image-for-fastapi).

-В нём установлены **разумные значения по умолчанию**, но можно изменять и обновлять конфигурацию с помощью **переменных окружения** или конфигурационных файлов.

+А если вам нужны несколько воркеров, просто используйте опцию командной строки `--workers`.

-Он также поддерживает прохождение **Подготовительных шагов при запуске контейнеров** при помощи скрипта.

+/// note | Технические подробности

-/// tip | Подсказка

+Этот Docker-образ был создан в то время, когда Uvicorn не умел управлять и перезапускать «упавших» воркеров, и приходилось использовать Gunicorn вместе с Uvicorn, что добавляло заметную сложность, лишь бы Gunicorn управлял и перезапускал воркеров Uvicorn.

-Для просмотра всех возможных настроек перейдите на страницу этого Docker-образа: tiangolo/uvicorn-gunicorn-fastapi.

+Но теперь, когда Uvicorn (и команда `fastapi`) поддерживают `--workers`, нет причин использовать базовый Docker-образ вместо сборки своего (кода получается примерно столько же 😅).

///

-### Количество процессов в официальном Docker-образе

-

-**Количество процессов** в этом образе **вычисляется автоматически** и зависит от доступного количества **ядер** центрального процессора.

-

-Это означает, что он будет пытаться **выжать** из процессора как можно больше **производительности**.

-

-Но вы можете изменять и обновлять конфигурацию с помощью **переменных окружения** и т.п.

-

-Поскольку количество процессов зависит от процессора, на котором работает контейнер, **объём потребляемой памяти** также будет зависеть от этого.

-

-А значит, если вашему приложению требуется много оперативной памяти (например, оно использует модели машинного обучения) и Ваш сервер имеет центральный процессор с большим количеством ядер, но **не слишком большим объёмом оперативной памяти**, то может дойти до того, что контейнер попытается занять памяти больше, чем доступно, из-за чего будет падение производительности (или сервер вовсе упадёт). 🚨

-

-

-### Написание `Dockerfile`

-

-Итак, теперь мы можем написать `Dockerfile` основанный на этом официальном Docker-образе:

-

-```Dockerfile

-FROM tiangolo/uvicorn-gunicorn-fastapi:python3.9

-

-COPY ./requirements.txt /app/requirements.txt

-

-RUN pip install --no-cache-dir --upgrade -r /app/requirements.txt

-

-COPY ./app /app

-```

-

-### Большие приложения

-

-Если вы успели ознакомиться с разделом [Приложения содержащие много файлов](../tutorial/bigger-applications.md){.internal-link target=_blank}, состоящие из множества файлов, Ваш Dockerfile может выглядеть так:

-

-```Dockerfile hl_lines="7"

-FROM tiangolo/uvicorn-gunicorn-fastapi:python3.9

-

-COPY ./requirements.txt /app/requirements.txt

+## Развёртывание образа контейнера { #deploy-the-container-image }

-RUN pip install --no-cache-dir --upgrade -r /app/requirements.txt

-

-COPY ./app /app/app

-```

-

-### Как им пользоваться

-

-Если вы используете **Kubernetes** (или что-то вроде того), скорее всего вам **не нужно** использовать официальный Docker-образ (или другой похожий) в качестве основы, так как управление **количеством запущенных контейнеров** должно быть настроено на уровне кластера. В таком случае лучше **создать образ с нуля**, как описано в разделе Создать [Docker-образ для FastAPI](#docker-fastapi).

-

-Официальный образ может быть полезен в отдельных случаях, описанных выше в разделе [Множество процессов внутри контейнера для особых случаев](#_11). Например, если ваше приложение **достаточно простое**, не требует запуска в кластере и способно уместиться в один контейнер, то его настройки по умолчанию будут работать довольно хорошо. Или же вы развертываете его с помощью **Docker Compose**, работаете на одном сервере и т. д

-

-## Развёртывание образа контейнера

-

-После создания образа контейнера существует несколько способов его развёртывания.

+После того как у вас есть образ контейнера (Docker), его можно развёртывать несколькими способами.

Например:

-* С использованием **Docker Compose** при развёртывании на одном сервере

-* С использованием **Kubernetes** в кластере

-* С использованием режима Docker Swarm в кластере

-* С использованием других инструментов, таких как Nomad

-* С использованием облачного сервиса, который будет управлять разворачиванием вашего контейнера

-

-## Docker-образ и Poetry

-

-Если вы пользуетесь Poetry для управления зависимостями вашего проекта, то можете использовать многоэтапную сборку образа:

-

-```{ .dockerfile .annotate }

-# (1)

-FROM python:3.9 as requirements-stage

-

-# (2)

-WORKDIR /tmp

-

-# (3)

-RUN pip install poetry

-

-# (4)

-COPY ./pyproject.toml ./poetry.lock* /tmp/

-

-# (5)

-RUN poetry export -f requirements.txt --output requirements.txt --without-hashes

-

-# (6)

-FROM python:3.9

-

-# (7)

-WORKDIR /code

-

-# (8)

-COPY --from=requirements-stage /tmp/requirements.txt /code/requirements.txt

-

-# (9)

-RUN pip install --no-cache-dir --upgrade -r /code/requirements.txt

-

-# (10)

-COPY ./app /code/app

-

-# (11)

-CMD ["uvicorn", "app.main:app", "--host", "0.0.0.0", "--port", "80"]

-```

-

-1. Это первый этап, которому мы дадим имя `requirements-stage`.

-

-2. Установите директорию `/tmp` в качестве рабочей директории.

+* С **Docker Compose** на одном сервере

+* В кластере **Kubernetes**

+* В кластере Docker Swarm Mode

+* С другим инструментом, например Nomad

+* С облачным сервисом, который принимает ваш образ контейнера и разворачивает его

- В ней будет создан файл `requirements.txt`

-

-3. На этом шаге установите Poetry.

-

-4. Скопируйте файлы `pyproject.toml` и `poetry.lock` в директорию `/tmp`.

-

- Поскольку название файла написано как `./poetry.lock*` (с `*` в конце), то ничего не сломается, если такой файл не будет найден.

-

-5. Создайте файл `requirements.txt`.

-

-6. Это второй (и последний) этап сборки, который и создаст окончательный образ контейнера.

-

-7. Установите директорию `/code` в качестве рабочей.

-

-8. Скопируйте файл `requirements.txt` в директорию `/code`.

-

- Этот файл находится в образе, созданном на предыдущем этапе, которому мы дали имя requirements-stage, потому при копировании нужно написать `--from-requirements-stage`.

-

-9. Установите зависимости, указанные в файле `requirements.txt`.

-

-10. Скопируйте папку `app` в папку `/code`.

-

-11. Запустите `uvicorn`, указав ему использовать объект `app`, расположенный в `app.main`.

-

-/// tip | Подсказка

-

-Если ткнёте на кружок с плюсом, то увидите объяснения, что происходит в этой строке.

-

-///

-

-**Этапы сборки Docker-образа** являются частью `Dockerfile` и работают как **временные образы контейнеров**. Они нужны только для создания файлов, используемых в дальнейших этапах.

-

-Первый этап был нужен только для **установки Poetry** и **создания файла `requirements.txt`**, в которым прописаны зависимости вашего проекта, взятые из файла `pyproject.toml`.

-

-На **следующем этапе** `pip` будет использовать файл `requirements.txt`.

-

-В итоговом образе будет содержаться **только последний этап сборки**, предыдущие этапы будут отброшены.

-

-При использовании Poetry, имеет смысл использовать **многоэтапную сборку Docker-образа**, потому что на самом деле вам не нужен Poetry и его зависимости в окончательном образе контейнера, вам **нужен только** сгенерированный файл `requirements.txt` для установки зависимостей вашего проекта.

-

-А на последнем этапе, придерживаясь описанных ранее правил, создаётся итоговый образ

-

-### Использование прокси-сервера завершения TLS и Poetry

-

-И снова повторюсь, если используете прокси-сервер (балансировщик нагрузки), такой как Nginx или Traefik, добавьте в команду запуска опцию `--proxy-headers`:

-

-```Dockerfile

-CMD ["uvicorn", "app.main:app", "--proxy-headers", "--host", "0.0.0.0", "--port", "80"]

-```

+## Docker-образ с `uv` { #docker-image-with-uv }

-## Резюме

+Если вы используете uv для установки и управления проектом, следуйте их руководству по Docker для uv.

-При помощи систем контейнеризации (таких, как **Docker** и **Kubernetes**), становится довольно просто обрабатывать все **концепции развертывания**:

+## Резюме { #recap }

-* Использование более безопасного протокола HTTPS

-* Настройки запуска приложения

-* Перезагрузка приложения

-* Запуск нескольких экземпляров приложения

-* Управление памятью

-* Использование перечисленных функций перед запуском приложения

+Используя системы контейнеризации (например, **Docker** и **Kubernetes**), довольно просто закрыть все **концепции развертывания**:

-В большинстве случаев Вам, вероятно, не нужно использовать какой-либо базовый образ, **лучше создать образ контейнера с нуля** на основе официального Docker-образа Python.

+* HTTPS

+* Запуск при старте

+* Перезапуски

+* Репликация (количество запущенных процессов)

+* Память

+* Предварительные шаги перед запуском

-Позаботившись о **порядке написания** инструкций в `Dockerfile`, вы сможете использовать **кэш Docker'а**, **минимизировав время сборки**, максимально повысив свою производительность (и не заскучать). 😎

+В большинстве случаев вы, вероятно, не захотите использовать какой-либо базовый образ, а вместо этого **соберёте образ контейнера с нуля** на основе официального Docker-образа Python.

-В некоторых особых случаях вы можете использовать официальный образ Docker для FastAPI. 🤓

+Заботясь о **порядке** инструкций в `Dockerfile`и используя **кэш Docker**, вы можете **минимизировать время сборки**, чтобы повысить продуктивность (и не скучать). 😎

diff --git a/docs/ru/docs/deployment/https.md b/docs/ru/docs/deployment/https.md

index d8877a9a1..05a03255e 100644

--- a/docs/ru/docs/deployment/https.md

+++ b/docs/ru/docs/deployment/https.md

@@ -1,207 +1,231 @@

-# Об HTTPS

+# Об HTTPS { #about-https }

-Обычно представляется, что HTTPS это некая опция, которая либо "включена", либо нет.

+Легко предположить, что HTTPS — это что-то, что просто «включено» или нет.

-Но всё несколько сложнее.

+Но на самом деле всё гораздо сложнее.

-/// tip | Заметка

+/// tip | Совет

-Если вы торопитесь или вам не интересно, можете перейти на следующую страницу этого пошагового руководства по размещению приложений на серверах с использованием различных технологий.

+Если вы торопитесь или вам это не важно, переходите к следующим разделам с пошаговыми инструкциями по настройке всего разными способами.

///

-Чтобы **изучить основы HTTPS** для клиента, перейдите по ссылке https://howhttps.works/.

-

-Здесь же представлены некоторые концепции, которые **разработчик** должен иметь в виду при размышлениях об HTTPS:

-

-* Протокол HTTPS предполагает, что **серверу** нужно **располагать "сертификатами"** сгенерированными **третьей стороной**.

- * На самом деле эти сертификаты **приобретены** у третьей стороны, а не "сгенерированы".

-* У сертификатов есть **срок годности**.

- * Срок годности **истекает**.

- * По истечении срока годности их нужно **обновить**, то есть **снова получить** у третьей стороны.

-* Шифрование соединения происходит **на уровне протокола TCP**.

- * Протокол TCP находится на один уровень **ниже протокола HTTP**.

- * Поэтому **проверка сертификатов и шифрование** происходит **до HTTP**.

-* **TCP не знает о "доменах"**, но знает об IP-адресах.

- * Информация о **запрашиваемом домене** извлекается из запроса **на уровне HTTP**.

-* **Сертификаты HTTPS** "сертифицируют" **конкретный домен**, но проверка сертификатов и шифрование данных происходит на уровне протокола TCP, то есть **до того**, как станет известен домен-получатель данных.

-* **По умолчанию** это означает, что у вас может быть **только один сертификат HTTPS на один IP-адрес**.

- * Не важно, насколько большой у вас сервер и насколько маленькие приложения на нём могут быть.

- * Однако, у этой проблемы есть **решение**.

-* Существует **расширение** протокола **TLS** (который работает на уровне TCP, то есть до HTTP) называемое **SNI**.

- * Расширение SNI позволяет одному серверу (с **одним IP-адресом**) иметь **несколько сертификатов HTTPS** и обслуживать **множество HTTPS-доменов/приложений**.

- * Чтобы эта конструкция работала, **один** её компонент (программа) запущенный на сервере и слушающий **публичный IP-адрес**, должен иметь **все сертификаты HTTPS** для этого сервера.

-* **После** установления защищённого соединения, протоколом передачи данных **остаётся HTTP**.

- * Но данные теперь **зашифрованы**, несмотря на то, что они передаются по **протоколу HTTP**.

-

-Обычной практикой является иметь **одну программу/HTTP-сервер** запущенную на сервере (машине, хосте и т.д.) и **ответственную за всю работу с HTTPS**:

-

-* получение **зашифрованных HTTPS-запросов**

-* отправка **расшифрованных HTTP запросов** в соответствующее HTTP-приложение, работающее на том же сервере (в нашем случае, это приложение **FastAPI**)

-* получение **HTTP-ответа** от приложения

-* **шифрование ответа** используя подходящий **сертификат HTTPS**

-* отправка зашифрованного **HTTPS-ответа клиенту**.

-Такой сервер часто называют **Прокси-сервер завершения работы TLS** или просто "прокси-сервер".

-

-Вот некоторые варианты, которые вы можете использовать в качестве такого прокси-сервера:

-

-* Traefik (может обновлять сертификаты)

-* Caddy (может обновлять сертификаты)

+Чтобы **изучить основы HTTPS** с точки зрения пользователя, загляните на https://howhttps.works/.

+

+Теперь, со стороны **разработчика**, вот несколько вещей, которые стоит держать в голове, размышляя об HTTPS:

+

+* Для HTTPS **серверу** нужно **иметь «сертификаты»**, сгенерированные **третьей стороной**.

+ * Эти сертификаты на самом деле **приобретаются** у третьей стороны, а не «генерируются».

+* У сертификатов есть **срок действия**.

+ * Они **истекают**.

+ * После этого их нужно **обновлять**, то есть **получать заново** у третьей стороны.

+* Шифрование соединения происходит на **уровне TCP**.

+ * Это на один уровень **ниже HTTP**.

+ * Поэтому **сертификаты и шифрование** обрабатываются **до HTTP**.

+* **TCP не знает о «доменах»**. Только об IP-адресах.

+ * Информация о **конкретном домене** передаётся в **данных HTTP**.

+* **HTTPS-сертификаты** «сертифицируют» **определённый домен**, но протокол и шифрование происходят на уровне TCP, **до того как** становится известен домен, с которым идёт работа.

+* **По умолчанию** это означает, что вы можете иметь **лишь один HTTPS-сертификат на один IP-адрес**.

+ * Неважно, насколько мощный у вас сервер или насколько маленькие приложения на нём работают.

+ * Однако у этого есть **решение**.

+* Есть **расширение** протокола **TLS** (того самого, что занимается шифрованием на уровне TCP, до HTTP) под названием **SNI**.

+ * Это расширение SNI позволяет одному серверу (с **одним IP-адресом**) иметь **несколько HTTPS-сертификатов** и обслуживать **несколько HTTPS-доменов/приложений**.

+ * Чтобы это работало, **один** компонент (программа), запущенный на сервере и слушающий **публичный IP-адрес**, должен иметь **все HTTPS-сертификаты** на этом сервере.

+* **После** установления защищённого соединения, протокол обмена данными — **всё ещё HTTP**.

+ * Содержимое **зашифровано**, несмотря на то, что оно отправляется по **протоколу HTTP**.

+

+Обычно на сервере (машине, хосте и т.п.) запускают **одну программу/HTTP‑сервер**, которая **управляет всей частью, связанной с HTTPS**: принимает **зашифрованные HTTPS-запросы**, отправляет **расшифрованные HTTP-запросы** в само HTTP‑приложение, работающее на том же сервере (в нашем случае это приложение **FastAPI**), получает **HTTP-ответ** от приложения, **шифрует его** с использованием подходящего **HTTPS‑сертификата** и отправляет клиенту по **HTTPS**. Такой сервер часто называют **прокси‑сервером TLS-терминации**.

+

+Некоторые варианты, которые вы можете использовать как прокси‑сервер TLS-терминации:

+

+* Traefik (умеет обновлять сертификаты)

+* Caddy (умеет обновлять сертификаты)

* Nginx

* HAProxy

-## Let's Encrypt (центр сертификации)

+## Let's Encrypt { #lets-encrypt }

-До появления Let's Encrypt **сертификаты HTTPS** приходилось покупать у третьих сторон.

+До появления Let's Encrypt эти **HTTPS-сертификаты** продавались доверенными третьими сторонами.

-Процесс получения такого сертификата был трудоёмким, требовал предоставления подтверждающих документов и сертификаты стоили дорого.

+Процесс получения таких сертификатов был неудобным, требовал бумажной волокиты, а сами сертификаты были довольно дорогими.

-Но затем консорциумом Linux Foundation был создан проект **Let's Encrypt**.

+Затем появился **Let's Encrypt**.

-Он автоматически предоставляет **бесплатные сертификаты HTTPS**. Эти сертификаты используют все стандартные криптографические способы шифрования. Они имеют небольшой срок годности (около 3 месяцев), благодаря чему они даже **более безопасны**.

+Это проект Linux Foundation. Он предоставляет **HTTPS‑сертификаты бесплатно**, в автоматическом режиме. Эти сертификаты используют стандартные криптографические механизмы и имеют короткий срок действия (около 3 месяцев), поэтому **безопасность фактически выше** благодаря уменьшенному сроку жизни.

-При запросе на получение сертификата, он автоматически генерируется и домен проверяется на безопасность. Это позволяет обновлять сертификаты автоматически.

+Домены безопасно проверяются, а сертификаты выдаются автоматически. Это также позволяет автоматизировать процесс их продления.

-Суть идеи в автоматическом получении и обновлении этих сертификатов, чтобы все могли пользоваться **безопасным HTTPS. Бесплатно. В любое время.**

+Идея — автоматизировать получение и продление сертификатов, чтобы у вас был **безопасный HTTPS, бесплатно и навсегда**.

-## HTTPS для разработчиков

+## HTTPS для разработчиков { #https-for-developers }

-Ниже, шаг за шагом, с заострением внимания на идеях, важных для разработчика, описано, как может выглядеть HTTPS API.

+Ниже приведён пример того, как может выглядеть HTTPS‑API, шаг за шагом, с акцентом на идеях, важных для разработчиков.

-### Имя домена

+### Имя домена { #domain-name }

-Чаще всего, всё начинается с **приобретения имени домена**. Затем нужно настроить DNS-сервер (вероятно у того же провайдера, который выдал вам домен).

+Чаще всего всё начинается с **приобретения** **имени домена**. Затем вы настраиваете его на DNS‑сервере (возможно, у того же облачного провайдера).

-Далее, возможно, вы получаете "облачный" сервер (виртуальную машину) или что-то типа этого, у которого есть постоянный **публичный IP-адрес**.

+Скорее всего, вы получите облачный сервер (виртуальную машину) или что-то подобное, и у него будет постоянный **публичный IP-адрес**.

-На DNS-сервере (серверах) вам следует настроить соответствующую ресурсную запись ("`запись A`"), указав, что **Ваш домен** связан с публичным **IP-адресом вашего сервера**.

+На DNS‑сервере(ах) вы настроите запись («`A record`» - запись типа A), указывающую, что **ваш домен** должен указывать на публичный **IP‑адрес вашего сервера**.

-Обычно эту запись достаточно указать один раз, при первоначальной настройке всего сервера.

+Обычно это делается один раз — при первоначальной настройке всего.

-/// tip | Заметка

+/// tip | Совет

-Уровни протоколов, работающих с именами доменов, намного ниже HTTPS, но об этом следует упомянуть здесь, так как всё зависит от доменов и IP-адресов.

+Часть про доменное имя относится к этапам задолго до HTTPS, но так как всё зависит от домена и IP‑адреса, здесь стоит это упомянуть.

///

-### DNS

+### DNS { #dns }

-Теперь давайте сфокусируемся на работе с HTTPS.

+Теперь сфокусируемся на собственно частях, связанных с HTTPS.

-Всё начинается с того, что браузер спрашивает у **DNS-серверов**, какой **IP-адрес связан с доменом**, для примера возьмём домен `someapp.example.com`.

+Сначала браузер спросит у **DNS‑серверов**, какой **IP соответствует домену**, в нашем примере `someapp.example.com`.

-DNS-сервера присылают браузеру определённый **IP-адрес**, тот самый публичный IP-адрес вашего сервера, который вы указали в ресурсной "записи А" при настройке.

+DNS‑серверы ответят браузеру, какой **конкретный IP‑адрес** использовать. Это будет публичный IP‑адрес вашего сервера, который вы указали в настройках DNS.

-### Рукопожатие TLS

+### Начало TLS-рукопожатия { #tls-handshake-start }

-В дальнейшем браузер будет взаимодействовать с этим IP-адресом через **port 443** (общепринятый номер порта для HTTPS).

+Далее браузер будет общаться с этим IP‑адресом на **порту 443** (порт HTTPS).

-Первым шагом будет установление соединения между клиентом (браузером) и сервером и выбор криптографического ключа (для шифрования).

+Первая часть взаимодействия — установить соединение между клиентом и сервером и договориться о криптографических ключах и т.п.

-### Рукопожатие TLS

+### Начало TLS-рукопожатия { #tls-handshake-start }

-В дальнейшем браузер будет взаимодействовать с этим IP-адресом через **port 443** (общепринятый номер порта для HTTPS).

+Далее браузер будет общаться с этим IP‑адресом на **порту 443** (порт HTTPS).

-Первым шагом будет установление соединения между клиентом (браузером) и сервером и выбор криптографического ключа (для шифрования).

+Первая часть взаимодействия — установить соединение между клиентом и сервером и договориться о криптографических ключах и т.п.

-Эта часть клиент-серверного взаимодействия устанавливает TLS-соединение и называется **TLS-рукопожатием**.

+Это взаимодействие клиента и сервера для установления TLS‑соединения называется **TLS‑рукопожатием**.

-### TLS с расширением SNI

+### TLS с расширением SNI { #tls-with-sni-extension }

-На сервере **только один процесс** может прослушивать определённый **порт** определённого **IP-адреса**. На сервере могут быть и другие процессы, слушающие другие порты этого же IP-адреса, но никакой процесс не может быть привязан к уже занятой комбинации IP-адрес:порт. Эта комбинация называется "сокет".

+На сервере **только один процесс** может слушать конкретный **порт** на конкретном **IP‑адресе**. Могут быть другие процессы, слушающие другие порты на том же IP‑адресе, но не более одного процесса на каждую комбинацию IP‑адреса и порта.

-По умолчанию TLS (HTTPS) использует порт `443`. Потому этот же порт будем использовать и мы.

+По умолчанию TLS (HTTPS) использует порт `443`. Значит, он нам и нужен.

-И раз уж только один процесс может слушать этот порт, то это будет процесс **прокси-сервера завершения работы TLS**.

+Так как только один процесс может слушать этот порт, делать это будет **прокси‑сервер TLS-терминации**.

-Прокси-сервер завершения работы TLS будет иметь доступ к одному или нескольким **TLS-сертификатам** (сертификаты HTTPS).

+У прокси‑сервера TLS-терминации будет доступ к одному или нескольким **TLS‑сертификатам** (HTTPS‑сертификатам).

-Используя **расширение SNI** упомянутое выше, прокси-сервер из имеющихся сертификатов TLS (HTTPS) выберет тот, который соответствует имени домена, указанному в запросе от клиента.

+Используя **расширение SNI**, упомянутое выше, прокси‑сервер TLS-терминации определит, какой из доступных TLS (HTTPS)‑сертификатов нужно использовать для этого соединения, выбрав тот, который соответствует домену, ожидаемому клиентом.

-То есть будет выбран сертификат для домена `someapp.example.com`.

+В нашем случае это будет сертификат для `someapp.example.com`.

-Эта часть клиент-серверного взаимодействия устанавливает TLS-соединение и называется **TLS-рукопожатием**.

+Это взаимодействие клиента и сервера для установления TLS‑соединения называется **TLS‑рукопожатием**.

-### TLS с расширением SNI

+### TLS с расширением SNI { #tls-with-sni-extension }

-На сервере **только один процесс** может прослушивать определённый **порт** определённого **IP-адреса**. На сервере могут быть и другие процессы, слушающие другие порты этого же IP-адреса, но никакой процесс не может быть привязан к уже занятой комбинации IP-адрес:порт. Эта комбинация называется "сокет".

+На сервере **только один процесс** может слушать конкретный **порт** на конкретном **IP‑адресе**. Могут быть другие процессы, слушающие другие порты на том же IP‑адресе, но не более одного процесса на каждую комбинацию IP‑адреса и порта.

-По умолчанию TLS (HTTPS) использует порт `443`. Потому этот же порт будем использовать и мы.

+По умолчанию TLS (HTTPS) использует порт `443`. Значит, он нам и нужен.

-И раз уж только один процесс может слушать этот порт, то это будет процесс **прокси-сервера завершения работы TLS**.

+Так как только один процесс может слушать этот порт, делать это будет **прокси‑сервер TLS-терминации**.

-Прокси-сервер завершения работы TLS будет иметь доступ к одному или нескольким **TLS-сертификатам** (сертификаты HTTPS).

+У прокси‑сервера TLS-терминации будет доступ к одному или нескольким **TLS‑сертификатам** (HTTPS‑сертификатам).

-Используя **расширение SNI** упомянутое выше, прокси-сервер из имеющихся сертификатов TLS (HTTPS) выберет тот, который соответствует имени домена, указанному в запросе от клиента.

+Используя **расширение SNI**, упомянутое выше, прокси‑сервер TLS-терминации определит, какой из доступных TLS (HTTPS)‑сертификатов нужно использовать для этого соединения, выбрав тот, который соответствует домену, ожидаемому клиентом.

-То есть будет выбран сертификат для домена `someapp.example.com`.

+В нашем случае это будет сертификат для `someapp.example.com`.

-Клиент уже **доверяет** тому, кто выдал этот TLS-сертификат (в нашем случае - Let's Encrypt, но мы ещё обсудим это), потому может **проверить**, действителен ли полученный от сервера сертификат.

+Клиент уже **доверяет** организации, выдавшей этот TLS‑сертификат (в нашем случае — Let's Encrypt, но об этом позже), поэтому может **проверить**, что сертификат действителен.

-Затем, используя этот сертификат, клиент и прокси-сервер **выбирают способ шифрования** данных для устанавливаемого **TCP-соединения**. На этом операция **TLS-рукопожатия** завершена.

+Затем, используя сертификат, клиент и прокси‑сервер TLS-терминации **договариваются о способе шифрования** остальной **TCP‑коммуникации**. На этом **TLS‑рукопожатие** завершено.

-В дальнейшем клиент и сервер будут взаимодействовать по **зашифрованному TCP-соединению**, как предлагается в протоколе TLS. И на основе этого TCP-соедениния будет создано **HTTP-соединение**.

+После этого у клиента и сервера есть **зашифрованное TCP‑соединение** — это и предоставляет TLS. И они могут использовать это соединение, чтобы начать собственно **HTTP‑обмен**.

-Таким образом, **HTTPS** это тот же **HTTP**, но внутри **безопасного TLS-соединения** вместо чистого (незашифрованного) TCP-соединения.

+Собственно, **HTTPS** — это обычный **HTTP** внутри **защищённого TLS‑соединения**, вместо чистого (незашифрованного) TCP‑соединения.

-/// tip | Заметка

+/// tip | Совет

-Обратите внимание, что шифрование происходит на **уровне TCP**, а не на более высоком уровне HTTP.

+Обратите внимание, что шифрование обмена происходит на **уровне TCP**, а не на уровне HTTP.

///

-### HTTPS-запрос

+### HTTPS‑запрос { #https-request }

-Теперь, когда между клиентом и сервером (в нашем случае, браузером и прокси-сервером) создано **зашифрованное TCP-соединение**, они могут начать **обмен данными по протоколу HTTP**.

+Теперь, когда у клиента и сервера (конкретно у браузера и прокси‑сервера TLS-терминации) есть **зашифрованное TCP‑соединение**, они могут начать **HTTP‑обмен**.

-Так клиент отправляет **HTTPS-запрос**. То есть обычный HTTP-запрос, но через зашифрованное TLS-содинение.

+Клиент отправляет **HTTPS‑запрос**. Это обычный HTTP‑запрос через зашифрованное TLS‑соединение.

-Клиент уже **доверяет** тому, кто выдал этот TLS-сертификат (в нашем случае - Let's Encrypt, но мы ещё обсудим это), потому может **проверить**, действителен ли полученный от сервера сертификат.

+Клиент уже **доверяет** организации, выдавшей этот TLS‑сертификат (в нашем случае — Let's Encrypt, но об этом позже), поэтому может **проверить**, что сертификат действителен.

-Затем, используя этот сертификат, клиент и прокси-сервер **выбирают способ шифрования** данных для устанавливаемого **TCP-соединения**. На этом операция **TLS-рукопожатия** завершена.

+Затем, используя сертификат, клиент и прокси‑сервер TLS-терминации **договариваются о способе шифрования** остальной **TCP‑коммуникации**. На этом **TLS‑рукопожатие** завершено.

-В дальнейшем клиент и сервер будут взаимодействовать по **зашифрованному TCP-соединению**, как предлагается в протоколе TLS. И на основе этого TCP-соедениния будет создано **HTTP-соединение**.

+После этого у клиента и сервера есть **зашифрованное TCP‑соединение** — это и предоставляет TLS. И они могут использовать это соединение, чтобы начать собственно **HTTP‑обмен**.

-Таким образом, **HTTPS** это тот же **HTTP**, но внутри **безопасного TLS-соединения** вместо чистого (незашифрованного) TCP-соединения.

+Собственно, **HTTPS** — это обычный **HTTP** внутри **защищённого TLS‑соединения**, вместо чистого (незашифрованного) TCP‑соединения.

-/// tip | Заметка

+/// tip | Совет

-Обратите внимание, что шифрование происходит на **уровне TCP**, а не на более высоком уровне HTTP.

+Обратите внимание, что шифрование обмена происходит на **уровне TCP**, а не на уровне HTTP.

///

-### HTTPS-запрос

+### HTTPS‑запрос { #https-request }

-Теперь, когда между клиентом и сервером (в нашем случае, браузером и прокси-сервером) создано **зашифрованное TCP-соединение**, они могут начать **обмен данными по протоколу HTTP**.

+Теперь, когда у клиента и сервера (конкретно у браузера и прокси‑сервера TLS-терминации) есть **зашифрованное TCP‑соединение**, они могут начать **HTTP‑обмен**.

-Так клиент отправляет **HTTPS-запрос**. То есть обычный HTTP-запрос, но через зашифрованное TLS-содинение.

+Клиент отправляет **HTTPS‑запрос**. Это обычный HTTP‑запрос через зашифрованное TLS‑соединение.

-### Расшифровка запроса

+### Расшифровка запроса { #decrypt-the-request }

-Прокси-сервер, используя согласованный с клиентом ключ, расшифрует полученный **зашифрованный запрос** и передаст **обычный (незашифрованный) HTTP-запрос** процессу, запускающему приложение (например, процессу Uvicorn запускающему приложение FastAPI).

+Прокси‑сервер TLS-терминации использует согласованное шифрование, чтобы **расшифровать запрос**, и передаёт **обычный (расшифрованный) HTTP‑запрос** процессу, запускающему приложение (например, процессу с Uvicorn, который запускает приложение FastAPI).

-### Расшифровка запроса

+### Расшифровка запроса { #decrypt-the-request }

-Прокси-сервер, используя согласованный с клиентом ключ, расшифрует полученный **зашифрованный запрос** и передаст **обычный (незашифрованный) HTTP-запрос** процессу, запускающему приложение (например, процессу Uvicorn запускающему приложение FastAPI).

+Прокси‑сервер TLS-терминации использует согласованное шифрование, чтобы **расшифровать запрос**, и передаёт **обычный (расшифрованный) HTTP‑запрос** процессу, запускающему приложение (например, процессу с Uvicorn, который запускает приложение FastAPI).

-### HTTP-ответ

+### HTTP‑ответ { #http-response }

-Приложение обработает запрос и вернёт **обычный (незашифрованный) HTTP-ответ** прокси-серверу.

+Приложение обработает запрос и отправит **обычный (незашифрованный) HTTP‑ответ** прокси‑серверу TLS-терминации.

-### HTTP-ответ

+### HTTP‑ответ { #http-response }

-Приложение обработает запрос и вернёт **обычный (незашифрованный) HTTP-ответ** прокси-серверу.

+Приложение обработает запрос и отправит **обычный (незашифрованный) HTTP‑ответ** прокси‑серверу TLS-терминации.

-### HTTPS-ответ

+### HTTPS‑ответ { #https-response }

-Пркоси-сервер **зашифрует ответ** используя ранее согласованный с клиентом способ шифрования (которые содержатся в сертификате для домена `someapp.example.com`) и отправит его браузеру.

+Затем прокси‑сервер TLS-терминации **зашифрует ответ** с использованием ранее согласованного способа шифрования (который начали использовать для сертификата для `someapp.example.com`) и отправит его обратно в браузер.

-Наконец, браузер проверит ответ, в том числе, что тот зашифрован с нужным ключом, **расшифрует его** и обработает.

+Далее браузер проверит, что ответ корректен и зашифрован правильным криптографическим ключом и т.п., затем **расшифрует ответ** и обработает его.

-### HTTPS-ответ

+### HTTPS‑ответ { #https-response }

-Пркоси-сервер **зашифрует ответ** используя ранее согласованный с клиентом способ шифрования (которые содержатся в сертификате для домена `someapp.example.com`) и отправит его браузеру.

+Затем прокси‑сервер TLS-терминации **зашифрует ответ** с использованием ранее согласованного способа шифрования (который начали использовать для сертификата для `someapp.example.com`) и отправит его обратно в браузер.

-Наконец, браузер проверит ответ, в том числе, что тот зашифрован с нужным ключом, **расшифрует его** и обработает.

+Далее браузер проверит, что ответ корректен и зашифрован правильным криптографическим ключом и т.п., затем **расшифрует ответ** и обработает его.

-Клиент (браузер) знает, что ответ пришёл от правильного сервера, так как использует методы шифрования, согласованные ими раннее через **HTTPS-сертификат**.

+Клиент (браузер) узнает, что ответ пришёл от правильного сервера, потому что используется способ шифрования, о котором они договорились ранее с помощью **HTTPS‑сертификата**.

-### Множество приложений

+### Несколько приложений { #multiple-applications }

-На одном и том же сервере (или серверах) можно разместить **множество приложений**, например, другие программы с API или базы данных.

+На одном и том же сервере (или серверах) могут работать **несколько приложений**, например другие программы с API или база данных.

-Напомню, что только один процесс (например, прокси-сервер) может прослушивать определённый порт определённого IP-адреса.

-Но другие процессы и приложения тоже могут работать на этом же сервере (серверах), если они не пытаются использовать уже занятую **комбинацию IP-адреса и порта** (сокет).

+Только один процесс может обрабатывать конкретную комбинацию IP и порта (в нашем примере — прокси‑сервер TLS-терминации), но остальные приложения/процессы тоже могут работать на сервере(ах), пока они не пытаются использовать ту же **комбинацию публичного IP и порта**.

-Клиент (браузер) знает, что ответ пришёл от правильного сервера, так как использует методы шифрования, согласованные ими раннее через **HTTPS-сертификат**.

+Клиент (браузер) узнает, что ответ пришёл от правильного сервера, потому что используется способ шифрования, о котором они договорились ранее с помощью **HTTPS‑сертификата**.

-### Множество приложений

+### Несколько приложений { #multiple-applications }

-На одном и том же сервере (или серверах) можно разместить **множество приложений**, например, другие программы с API или базы данных.

+На одном и том же сервере (или серверах) могут работать **несколько приложений**, например другие программы с API или база данных.

-Напомню, что только один процесс (например, прокси-сервер) может прослушивать определённый порт определённого IP-адреса.

-Но другие процессы и приложения тоже могут работать на этом же сервере (серверах), если они не пытаются использовать уже занятую **комбинацию IP-адреса и порта** (сокет).

+Только один процесс может обрабатывать конкретную комбинацию IP и порта (в нашем примере — прокси‑сервер TLS-терминации), но остальные приложения/процессы тоже могут работать на сервере(ах), пока они не пытаются использовать ту же **комбинацию публичного IP и порта**.

-Таким образом, сервер завершения TLS может обрабатывать HTTPS-запросы и использовать сертификаты для **множества доменов** или приложений и передавать запросы правильным адресатам (другим приложениям).

+Таким образом, прокси‑сервер TLS-терминации может обрабатывать HTTPS и сертификаты для **нескольких доменов** (для нескольких приложений), а затем передавать запросы нужному приложению в каждом случае.

-### Обновление сертификата

+### Продление сертификата { #certificate-renewal }

-В недалёком будущем любой сертификат станет **просроченным** (примерно через три месяца после получения).

+Со временем каждый сертификат **истечёт** (примерно через 3 месяца после получения).

-Когда это произойдёт, можно запустить другую программу, которая подключится к Let's Encrypt и обновит сертификат(ы). Существуют прокси-серверы, которые могут сделать это действие самостоятельно.

+Затем будет другая программа (иногда это отдельная программа, иногда — тот же прокси‑сервер TLS-терминации), которая свяжется с Let's Encrypt и продлит сертификат(ы).

-Таким образом, сервер завершения TLS может обрабатывать HTTPS-запросы и использовать сертификаты для **множества доменов** или приложений и передавать запросы правильным адресатам (другим приложениям).

+Таким образом, прокси‑сервер TLS-терминации может обрабатывать HTTPS и сертификаты для **нескольких доменов** (для нескольких приложений), а затем передавать запросы нужному приложению в каждом случае.

-### Обновление сертификата

+### Продление сертификата { #certificate-renewal }

-В недалёком будущем любой сертификат станет **просроченным** (примерно через три месяца после получения).

+Со временем каждый сертификат **истечёт** (примерно через 3 месяца после получения).

-Когда это произойдёт, можно запустить другую программу, которая подключится к Let's Encrypt и обновит сертификат(ы). Существуют прокси-серверы, которые могут сделать это действие самостоятельно.

+Затем будет другая программа (иногда это отдельная программа, иногда — тот же прокси‑сервер TLS-терминации), которая свяжется с Let's Encrypt и продлит сертификат(ы).

-**TLS-сертификаты** не привязаны к IP-адресу, но **связаны с именем домена**.

+**TLS‑сертификаты** **связаны с именем домена**, а не с IP‑адресом.

-Так что при обновлении сертификатов программа должна **подтвердить** центру сертификации (Let's Encrypt), что обновление запросил **"владелец", который контролирует этот домен**.

+Поэтому, чтобы продлить сертификаты, программа продления должна **доказать** удостоверяющему центру (Let's Encrypt), что она действительно **«владеет» и контролирует этот домен**.

-Есть несколько путей осуществления этого. Самые популярные из них:

+Для этого, учитывая разные потребности приложений, есть несколько способов. Популярные из них:

-* **Изменение записей DNS**.

- * Для такого варианта Ваша программа обновления должна уметь работать с API DNS-провайдера, обслуживающего Ваши DNS-записи. Не у всех провайдеров есть такой API, так что этот способ не всегда применим.

-* **Запуск в качестве программы-сервера** (как минимум, на время обновления сертификатов) на публичном IP-адресе домена.

- * Как уже не раз упоминалось, только один процесс может прослушивать определённый порт определённого IP-адреса.

- * Это одна из причин использования прокси-сервера ещё и в качестве программы обновления сертификатов.

- * В случае, если обновлением сертификатов занимается другая программа, вам понадобится остановить прокси-сервер, запустить программу обновления сертификатов на сокете, предназначенном для прокси-сервера, настроить прокси-сервер на работу с новыми сертификатами и перезапустить его. Эта схема далека от идеальной, так как Ваши приложения будут недоступны на время отключения прокси-сервера.

+* **Изменить некоторые DNS‑записи**.

+ * Для этого программа продления должна поддерживать API DNS‑провайдера, поэтому, в зависимости от используемого провайдера DNS, этот вариант может быть доступен или нет.

+* **Запуститься как сервер** (как минимум на время получения сертификатов) на публичном IP‑адресе, связанном с доменом.

+ * Как сказано выше, только один процесс может слушать конкретный IP и порт.

+ * Это одна из причин, почему очень удобно, когда тот же прокси‑сервер TLS-терминации также занимается процессом продления сертификатов.

+ * В противном случае вам, возможно, придётся временно остановить прокси‑сервер TLS-терминации, запустить программу продления для получения сертификатов, затем настроить их в прокси‑сервере TLS-терминации и перезапустить его. Это не идеально, так как ваше приложение(я) будут недоступны, пока прокси‑сервер TLS-терминации остановлен.

-Весь этот процесс обновления, одновременный с обслуживанием запросов, является одной из основных причин, по которой желательно иметь **отдельную систему для работы с HTTPS** в виде прокси-сервера завершения TLS, а не просто использовать сертификаты TLS непосредственно с сервером приложений (например, Uvicorn).

+Весь этот процесс продления, совмещённый с обслуживанием приложения, — одна из главных причин иметь **отдельную систему для работы с HTTPS** в виде прокси‑сервера TLS-терминации, вместо использования TLS‑сертификатов напрямую в сервере приложения (например, Uvicorn).

-## Резюме

+## Пересылаемые HTTP-заголовки прокси { #proxy-forwarded-headers }

-Наличие **HTTPS** очень важно и довольно **критично** в большинстве случаев. Однако, Вам, как разработчику, не нужно тратить много сил на это, достаточно **понимать эти концепции** и принципы их работы.

+Когда вы используете прокси для обработки HTTPS, ваш **сервер приложения** (например, Uvicorn через FastAPI CLI) ничего не знает о процессе HTTPS, он общается обычным HTTP с **прокси‑сервером TLS-терминации**.

-Но узнав базовые основы **HTTPS** вы можете легко совмещать разные инструменты, которые помогут вам в дальнейшей разработке.

+Обычно этот **прокси** на лету добавляет некоторые HTTP‑заголовки перед тем, как переслать запрос на **сервер приложения**, чтобы тот знал, что запрос был **проксирован**.

-В следующих главах я покажу вам несколько примеров, как настраивать **HTTPS** для приложений **FastAPI**. 🔒

+/// note | Технические детали

+

+Заголовки прокси:

+

+* X-Forwarded-For

+* X-Forwarded-Proto

+* X-Forwarded-Host

+

+///

+

+Тем не менее, так как **сервер приложения** не знает, что он находится за доверенным **прокси**, по умолчанию он не будет доверять этим заголовкам.

+

+Но вы можете настроить **сервер приложения**, чтобы он доверял *пересылаемым* заголовкам, отправленным **прокси**. Если вы используете FastAPI CLI, вы можете использовать *опцию CLI* `--forwarded-allow-ips`, чтобы указать, с каких IP‑адресов следует доверять этим *пересылаемым* заголовкам.

+

+Например, если **сервер приложения** получает запросы только от доверенного **прокси**, вы можете установить `--forwarded-allow-ips="*"`, чтобы доверять всем входящим IP, так как он всё равно будет получать запросы только с IP‑адреса, используемого **прокси**.

+

+Таким образом, приложение сможет знать свой публичный URL, использует ли оно HTTPS, какой домен и т.п.

+

+Это будет полезно, например, для корректной обработки редиректов.

+

+/// tip | Совет

+

+Подробнее об этом вы можете узнать в документации: [За прокси — Включить пересылаемые заголовки прокси](../advanced/behind-a-proxy.md#enable-proxy-forwarded-headers){.internal-link target=_blank}

+

+///

+

+## Резюме { #recap }

+

+Наличие **HTTPS** очень важно и во многих случаях довольно **критично**. Большая часть усилий, которые вам, как разработчику, нужно приложить вокруг HTTPS, — это просто **понимание этих концепций** и того, как они работают.

+

+Зная базовую информацию о **HTTPS для разработчиков**, вы сможете легко комбинировать и настраивать разные инструменты, чтобы управлять всем этим простым способом.

+

+В некоторых из следующих глав я покажу вам несколько конкретных примеров настройки **HTTPS** для приложений **FastAPI**. 🔒

diff --git a/docs/ru/docs/deployment/index.md b/docs/ru/docs/deployment/index.md

index e88ddc3e2..c85fa0d52 100644

--- a/docs/ru/docs/deployment/index.md

+++ b/docs/ru/docs/deployment/index.md

@@ -1,16 +1,16 @@

-# Развёртывание

+# Развёртывание { #deployment }

Развернуть приложение **FastAPI** довольно просто.

-## Да что такое это ваше - "развёртывание"?!

+## Что означает развёртывание { #what-does-deployment-mean }

Термин **развёртывание** (приложения) означает выполнение необходимых шагов, чтобы сделать приложение **доступным для пользователей**.

-Обычно **веб-приложения** размещают на удалённом компьютере с серверной программой, которая обеспечивает хорошую производительность, стабильность и т. д., Чтобы ваши пользователи могли эффективно, беспрерывно и беспроблемно обращаться к приложению.

+Для **веб-API** это обычно означает размещение его на **удалённой машине** с **серверной программой**, обеспечивающей хорошую производительность, стабильность и т.д., чтобы ваши **пользователи** могли **получать доступ** к приложению эффективно и без перебоев или проблем.

-Это отличается от **разработки**, когда вы постоянно меняете код, делаете в нём намеренные ошибки и исправляете их, останавливаете и перезапускаете сервер разработки и т. д.

+Это отличается от этапов **разработки**, когда вы постоянно меняете код, ломаете его и исправляете, останавливаете и перезапускаете сервер разработки и т.д.

-## Стратегии развёртывания

+## Стратегии развёртывания { #deployment-strategies }

В зависимости от вашего конкретного случая, есть несколько способов сделать это.

diff --git a/docs/ru/docs/deployment/manually.md b/docs/ru/docs/deployment/manually.md

index 9b1d32be8..37fed5780 100644

--- a/docs/ru/docs/deployment/manually.md

+++ b/docs/ru/docs/deployment/manually.md

@@ -1,163 +1,157 @@

-# Запуск сервера вручную - Uvicorn

+# Запуск сервера вручную { #run-a-server-manually }

-Для запуска приложения **FastAPI** на удалённой серверной машине вам необходим программный сервер, поддерживающий протокол ASGI, такой как **Uvicorn**.

+## Используйте команду `fastapi run` { #use-the-fastapi-run-command }

-Существует три наиболее распространённые альтернативы:

+Коротко: используйте `fastapi run`, чтобы запустить ваше приложение FastAPI:

-* Uvicorn: высокопроизводительный ASGI сервер.

-* Hypercorn: ASGI сервер, помимо прочего поддерживающий HTTP/2 и Trio.

-* Daphne: ASGI сервер, созданный для Django Channels.

-

-## Сервер как машина и сервер как программа

-

-В этих терминах есть некоторые различия и вам следует запомнить их. 💡

-

-Слово "**сервер**" чаще всего используется в двух контекстах:

+

-**TLS-сертификаты** не привязаны к IP-адресу, но **связаны с именем домена**.

+**TLS‑сертификаты** **связаны с именем домена**, а не с IP‑адресом.

-Так что при обновлении сертификатов программа должна **подтвердить** центру сертификации (Let's Encrypt), что обновление запросил **"владелец", который контролирует этот домен**.

+Поэтому, чтобы продлить сертификаты, программа продления должна **доказать** удостоверяющему центру (Let's Encrypt), что она действительно **«владеет» и контролирует этот домен**.

-Есть несколько путей осуществления этого. Самые популярные из них:

+Для этого, учитывая разные потребности приложений, есть несколько способов. Популярные из них:

-* **Изменение записей DNS**.

- * Для такого варианта Ваша программа обновления должна уметь работать с API DNS-провайдера, обслуживающего Ваши DNS-записи. Не у всех провайдеров есть такой API, так что этот способ не всегда применим.

-* **Запуск в качестве программы-сервера** (как минимум, на время обновления сертификатов) на публичном IP-адресе домена.

- * Как уже не раз упоминалось, только один процесс может прослушивать определённый порт определённого IP-адреса.

- * Это одна из причин использования прокси-сервера ещё и в качестве программы обновления сертификатов.

- * В случае, если обновлением сертификатов занимается другая программа, вам понадобится остановить прокси-сервер, запустить программу обновления сертификатов на сокете, предназначенном для прокси-сервера, настроить прокси-сервер на работу с новыми сертификатами и перезапустить его. Эта схема далека от идеальной, так как Ваши приложения будут недоступны на время отключения прокси-сервера.

+* **Изменить некоторые DNS‑записи**.

+ * Для этого программа продления должна поддерживать API DNS‑провайдера, поэтому, в зависимости от используемого провайдера DNS, этот вариант может быть доступен или нет.

+* **Запуститься как сервер** (как минимум на время получения сертификатов) на публичном IP‑адресе, связанном с доменом.

+ * Как сказано выше, только один процесс может слушать конкретный IP и порт.

+ * Это одна из причин, почему очень удобно, когда тот же прокси‑сервер TLS-терминации также занимается процессом продления сертификатов.

+ * В противном случае вам, возможно, придётся временно остановить прокси‑сервер TLS-терминации, запустить программу продления для получения сертификатов, затем настроить их в прокси‑сервере TLS-терминации и перезапустить его. Это не идеально, так как ваше приложение(я) будут недоступны, пока прокси‑сервер TLS-терминации остановлен.

-Весь этот процесс обновления, одновременный с обслуживанием запросов, является одной из основных причин, по которой желательно иметь **отдельную систему для работы с HTTPS** в виде прокси-сервера завершения TLS, а не просто использовать сертификаты TLS непосредственно с сервером приложений (например, Uvicorn).

+Весь этот процесс продления, совмещённый с обслуживанием приложения, — одна из главных причин иметь **отдельную систему для работы с HTTPS** в виде прокси‑сервера TLS-терминации, вместо использования TLS‑сертификатов напрямую в сервере приложения (например, Uvicorn).

-## Резюме

+## Пересылаемые HTTP-заголовки прокси { #proxy-forwarded-headers }

-Наличие **HTTPS** очень важно и довольно **критично** в большинстве случаев. Однако, Вам, как разработчику, не нужно тратить много сил на это, достаточно **понимать эти концепции** и принципы их работы.

+Когда вы используете прокси для обработки HTTPS, ваш **сервер приложения** (например, Uvicorn через FastAPI CLI) ничего не знает о процессе HTTPS, он общается обычным HTTP с **прокси‑сервером TLS-терминации**.

-Но узнав базовые основы **HTTPS** вы можете легко совмещать разные инструменты, которые помогут вам в дальнейшей разработке.

+Обычно этот **прокси** на лету добавляет некоторые HTTP‑заголовки перед тем, как переслать запрос на **сервер приложения**, чтобы тот знал, что запрос был **проксирован**.

-В следующих главах я покажу вам несколько примеров, как настраивать **HTTPS** для приложений **FastAPI**. 🔒

+/// note | Технические детали

+

+Заголовки прокси:

+

+* X-Forwarded-For

+* X-Forwarded-Proto

+* X-Forwarded-Host

+

+///

+

+Тем не менее, так как **сервер приложения** не знает, что он находится за доверенным **прокси**, по умолчанию он не будет доверять этим заголовкам.

+

+Но вы можете настроить **сервер приложения**, чтобы он доверял *пересылаемым* заголовкам, отправленным **прокси**. Если вы используете FastAPI CLI, вы можете использовать *опцию CLI* `--forwarded-allow-ips`, чтобы указать, с каких IP‑адресов следует доверять этим *пересылаемым* заголовкам.

+